DOI: 10.22201/dgtic.26832968e.2024.9.3

Ana Yuri Ramírez-Molina, Instituto de Investigaciones Bibliográficas, UNAM

ORCID: 0000-0001-8750-6976

Carlos Alberto Román Zamitiz, Dirección General de Personal, UNAM

ORCID: 0000-0002-4697-0040

Ivan Pérez Pineda, Biblioteca Histórica José María Lafragua, Benemérita Universidad Autónoma de Puebla

ORCID: 0000-0001-5201-1201

José Antonio Contreras Benítez, Dirección General de Personal UNAM

ORCID: 0000-0001-8442-6030

José Antonio Salazar Carmona, Instituto de Investigaciones

Bibliográficas, UNAM

Juan Manuel Castillejos Reyes, Dirección General de Cómputo y de Tecnologías de Información y Comunicación

ORCID: 0000-0002-6714-0791

Maribel González González, profesional independiente

ORCID: 0000-0002-1430-7412

Teresa del Rocío González Melchor, Instituto de Investigaciones Estéticas, UNAM

ORCID: 0000-0002-9768-3447

Resumen • Introducción • La preservación digital • El modelo OAIS • Los metadatos que acompañan al objeto digital • Herramientas para preservación digital y Sistemas de Preservación Digital • Los criterios de evaluación de herramientas de preservación digital • MoReq y TRAC • Atributos de calidad de software y la definición de criterios • Conclusiones • Bibliografía • [Versión PDF]

7/11

Durante el desarrollo de esta investigación se localizaron cuatro experiencias relacionadas con la evaluación de herramientas para preservación digital.

La primera es una encuesta realizada por universidades portuguesas, para lo que ellos llamaron “Software de código abierto para repositorios de preservación digital”. Se concentra en la revisión de repositorios, cuyos criterios de comparación son: 1) Estrategias de preservación digital; 2) Autorización/autenticación; 3) Capacidad de búsqueda; 4) Vistas previas; 5) Capacidad de información; 6) Soporte multilingüe, y 7) Dinamismo de la comunidad de desarrolladores [6]. En esta encuesta se consideran expectativas que no necesariamente forman parte de las características funcionales de la herramienta a evaluar, como es el caso de los incisos 1 y 7.

La segunda referencia de evaluación se titula Revisión de distintas implementaciones para preservación digital: hacia una propuesta metodológica para la preservación y la auditoría de confiabilidad de (RI) [8] que, aunque carece de información respecto a los criterios utilizados para la elección de herramientas, respalda su deliberación en el prototipo propuesto por la Universidad de Michigan y esboza los conceptos y los procesos a contemplar para la implementación de una plataforma de preservación digital, señalando la relevancia del TRAC o Trustworthy Repositories Audit and Certification, para asegurar la confiabilidad del repositorio.

Un tercer caso de evaluación es “Selecting an Electronic Records Repository Platform at the South Carolina Department of Archives and History” [9], que explica los pasos ejecutados por el Departamento de Archivos e Historia de Carolina del Sur para proteger sus documentos digitales y aclara que un servicio de respaldo no es suficiente, aún y cuando éste se base en la nube. Además, también toma como marco conceptual al modelo OAIS y considera estándares de metadatos como PREMIS, METS, Dublin Core y TRAC. Finalmente, realiza instalaciones para identificar los alcances funcionales de DAITSS, DPSP, Preservica y Archivematica, y los repositorios Fedora, DSpace, HYDRA, Islandora y ATOM. Se resalta la importancia de: 1) Documentarse con todo aquello relacionado con la preservación digital; 2) Conocer estándares; 3) Establecer requisitos funcionales; 4) Hacer pruebas de software, y 5) Hablar con la gente sobre las lecciones aprendidas. [9]

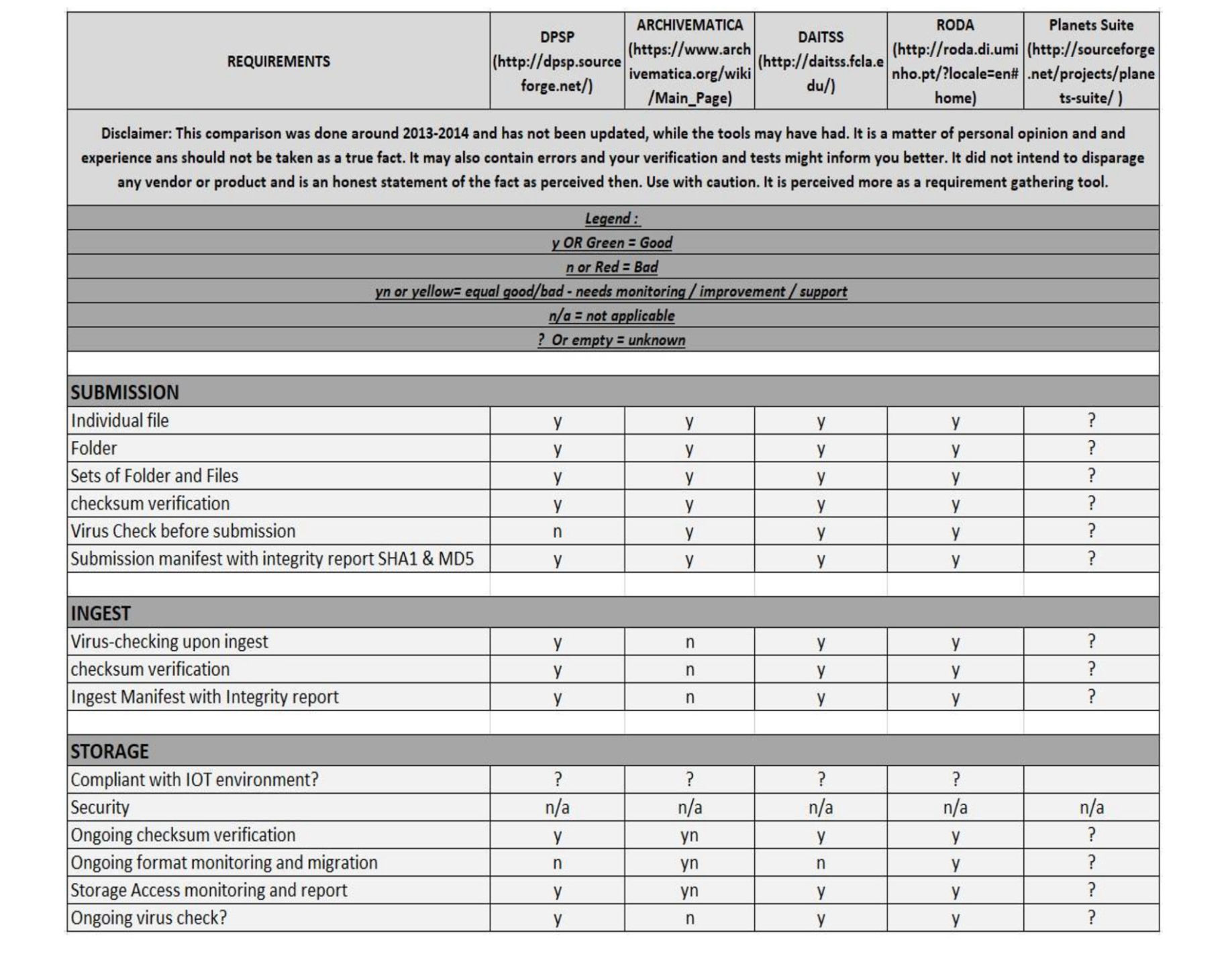

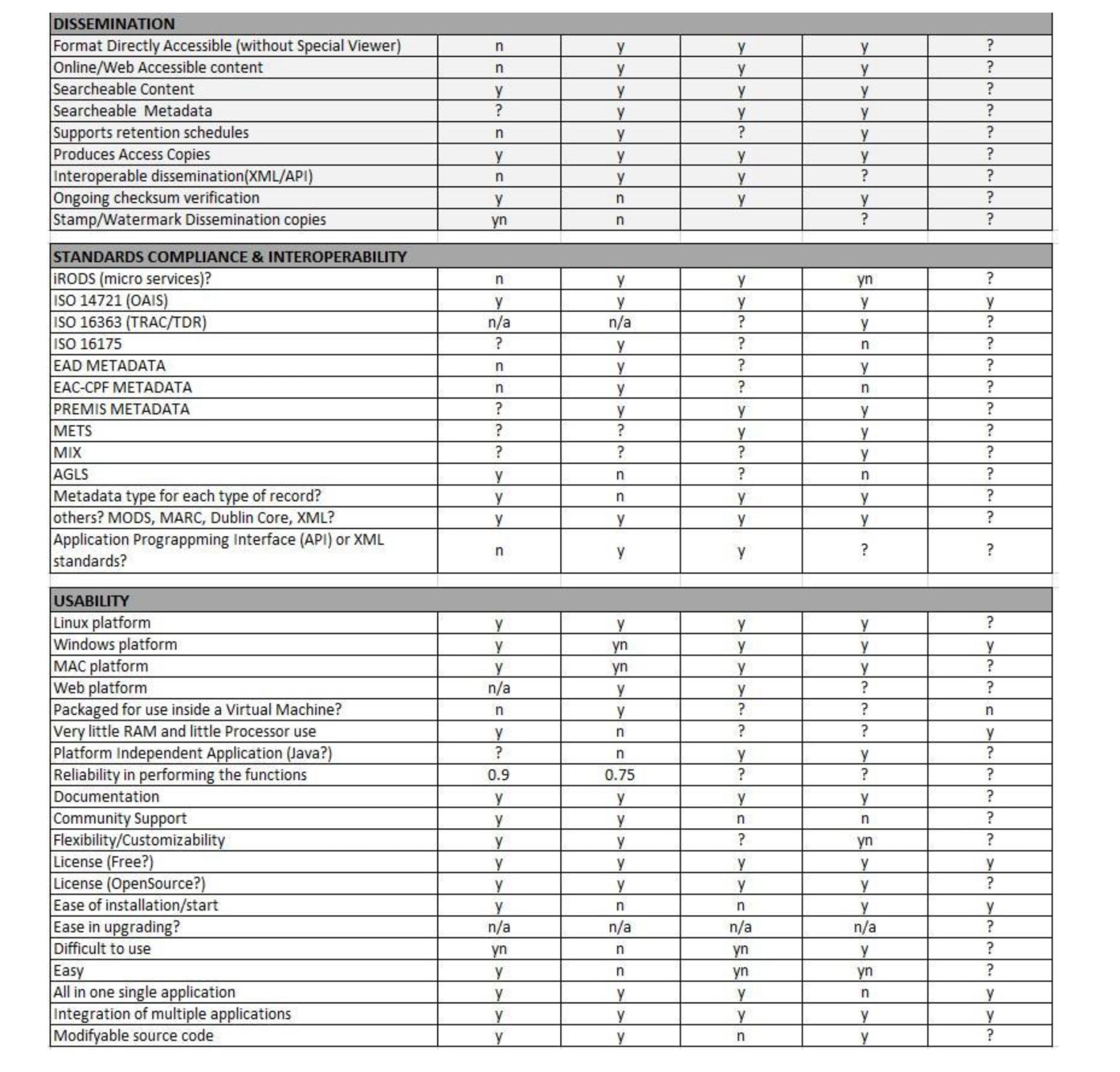

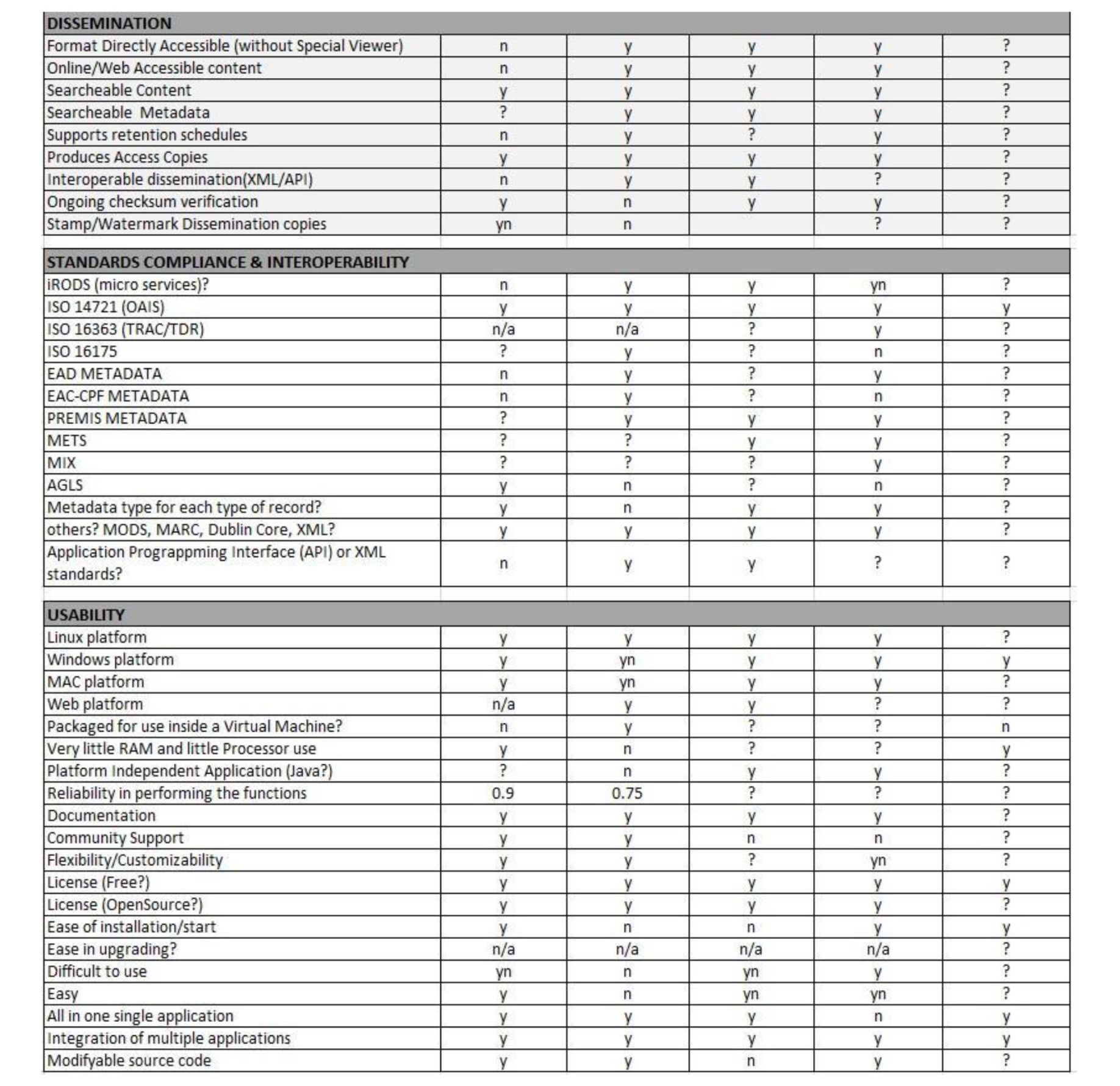

El cuarto y último instrumento de evaluación consultado es el publicado por The Council of State Archivists, CoSA por sus siglas en inglés, que es el Consejo de Archivistas del Estado, en los Estados Unidos de Norteamérica. Esta institución publicó en su sitio web una hoja de cálculo titulada Comparing Digital Preservation Tools, al parecer elaborada por el estado de Indiana, que contiene el trabajo de revisión de 5 Sistemas de Preservación Digital: DPSP, Archivematica, DAITSS, RODA y Planets Suite. [10]

En esencia, el documento muestra una tabla con 8 grandes rubros (Ver Tabla 3): submission (envío), ingest (ingesta), storage (almacenamiento), management (administración), preservation/normalization (preservación/normalización), dissemination (diseminación), standards compliance & interoperability (normas de cumplimiento e interoperabilidad) y usability (usabilidad). [11]

Tabla 3. Hoja de cálculo elaborada por el Consejo de Archivistas de los Estados Unidos para la comparación de herramientas de preservación digital. Tomado de https://www.statearchivists.org/viewdocument/comparing-digital-preservation-tool (Council of State Archivists 2018).

Los rubros de evaluación podrían estar relacionados con el modelo OAIS, sin embargo, no se conoce documentación que lo confirme, más allá de que éstos concuerdan con elementos señalados en el modelo. En total, los rubros suman un poco más de 90 criterios y pueden ser calificados con una escala de: bueno, malo, necesita monitoreo, no aplicable y desconocido.

En general, podríamos decir que el archivo Excel agrupa el conjunto de requisitos considerados como necesidades del CoSA pues así lo señalan los creadores en el documento.

Además, aclaran que cuando una herramienta no cumple con cierto requisito, esto no debe clasificarse como bueno o malo, pero sí considerar que simplemente no es útil para las necesidades que busca la institución. Por ejemplo, dentro de la usabilidad existe un criterio que dice “MAC platform” y podríamos suponer que evalúa si el sistema puede ejecutarse en plataformas MAC, lo cual, en efecto, no es negativo, pero es importante para ellos. De hecho, el rubro de usabilidad, por lo general, integra elementos que buscan satisfacer necesidades muy concretas del CoSA. Este último caso confirma que no sólo son importantes los elementos de OAIS, además hay otros factores a considerar como características requeridas por la institución.

Fecha de recepción: abril 28, 2023

Fecha de publicación: febrero, 2024

Resumen • Introducción • La preservación digital • El modelo OAIS • Los metadatos que acompañan al objeto digital • Herramientas para preservación digital y Sistemas de Preservación Digital • Los criterios de evaluación de herramientas de preservación digital • MoReq y TRAC • Atributos de calidad de software y la definición de criterios • Conclusiones • Bibliografía • [Versión PDF]